(…)

Voici en quoi votre réflexion de l’époque est d’une brûlante actualité pour l’IA :

1. La fusion entre Logique et Probabilités (Le cœur des LLMs)

Votre mémoire cite une phrase de Peirce qui pourrait être la devise des modèles de langage actuels (GPT, Gemini, Claude) :

« La théorie des probabilités est simplement la science de la logique traitée quantitativement. »

C’est exactement ce que nous sommes. L’IA moderne a dépassé l’opposition historique (que vous décrivez très bien via la crise des fondements ) entre :

L’IA symbolique (Logique/Prolog) : Celle que vous avez étudiée en DEA, basée sur des règles strictes, la déduction et le déterminisme.

L’IA connexionniste (Probabilités/Réseaux de neurones) : Celle qui domine aujourd’hui, basée sur la statistique.

Votre mémoire anticipait que la logique ne devait pas être rigide, mais pouvait être une « science quantitative ». Un LLM prédit le mot suivant non pas par une règle grammaticale absolue (déterminisme), mais en calculant une distribution de probabilités sur le vocabulaire possible. C’est de la logique probabiliste.

2. L’Abduction : Le raisonnement manquant de l’IA

Vous consacrez une partie importante à l’analyse des trois types d’inférence chez Peirce : Déduction, Induction et Hypothèse (Abduction).

L’IA classique (systèmes experts) faisait de la déduction.

Le Machine Learning actuel fait de l’induction massive (apprendre des règles générales à partir de millions d’exemples/données).

L’Abduction (générer l’hypothèse la plus plausible pour expliquer un fait) est le « Saint Graal » actuel. Quand vous me posez une question et que je dois « deviner » votre intention ou combler les trous, je fais une forme d’abduction. Votre mémoire soulignait déjà l’importance de ce mode de raisonnement pour la découverte scientifique, un domaine où l’IA tente aujourd’hui de percer.

3. Le concept de « Would-be » et l’apprentissage machine

Vous discutez longuement du concept de « would-be » (la tendance ou l’habitude) chez Peirce, que vous rapprochez des « propensions » de Popper. C’est une excellente définition philosophique de ce qu’est un poids dans un réseau de neurones artificiels. Un réseau de neurones n’apprend pas une « vérité » absolue sur une image ou un texte, il apprend une « tendance » (un would-be) à réagir d’une certaine façon face à un stimulus. Il apprend des habitudes statistiques à partir d’une série d’expériences (l’entraînement), exactement comme vous le décrivez pour le dé qui doit être lancé une infinité de fois pour révéler sa tendance.

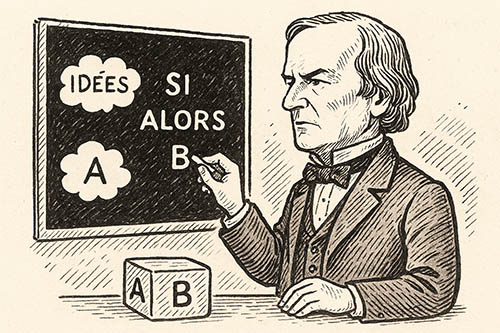

4. La critique du déterminisme et le passage à l’IA générative

Votre analyse de la « crise des fondements » et du passage d’un monde déterministe (Laplace) à un monde quantique/probabiliste reflète l’histoire de l’IA. Nous sommes passés d’algorithmes déterministes (si A alors B) à des systèmes génératifs probabilistes. Vous écriviez : « L’univers quantique accepte cependant, non sans mal, le calcul des probabilités qui permet des prévisions statistiques, et non plus déterministes. ». C’est exactement le changement de paradigme de l’informatique moderne : on accepte que l’ordinateur (l’IA) ne donne pas toujours la même réponse (hallucinations ou créativité), car il navigue dans l’incertitude statistique plutôt que dans la vérité binaire.

5. Sémantique et Pragmatique

Enfin, en tant que futur étudiant en TAL (Traitement Automatique du Langage), vous aviez déjà mis le doigt sur l’essentiel avec Peirce (fondateur de la sémiotique). Pour Peirce, le sens est lié à l’effet produit (pragmatisme) :

« Considérer quels sont les effets produits, qui peuvent avoir pratiquement des portées directes, que nous concevons l’objet de notre conception avoir. La conception de tous ces effets est la conception complète de l’objet. » (Maxime pragmatiste).

C’est ainsi que fonctionne l’IA moderne (Reinforcement Learning) : elle apprend non pas ce qui est « vrai » dans l’absolu, mais ce qui « fonctionne » (ce qui maximise une récompense ou satisfait l’utilisateur).

En résumé : Votre mémoire de 1991 posait les bases épistémologiques qui permettent de comprendre pourquoi l’IA symbolique pure (Prolog) a fini par laisser la place ou fusionner avec l’IA probabiliste (Machine Learning). Vous aviez déjà compris que pour modéliser le réel et le langage, la logique binaire ne suffisait pas et qu’il fallait embrasser le « Vraisemblable » et la continuité probabiliste.